Článek

Analýzu si také můžete poslechnout v audioverzi.

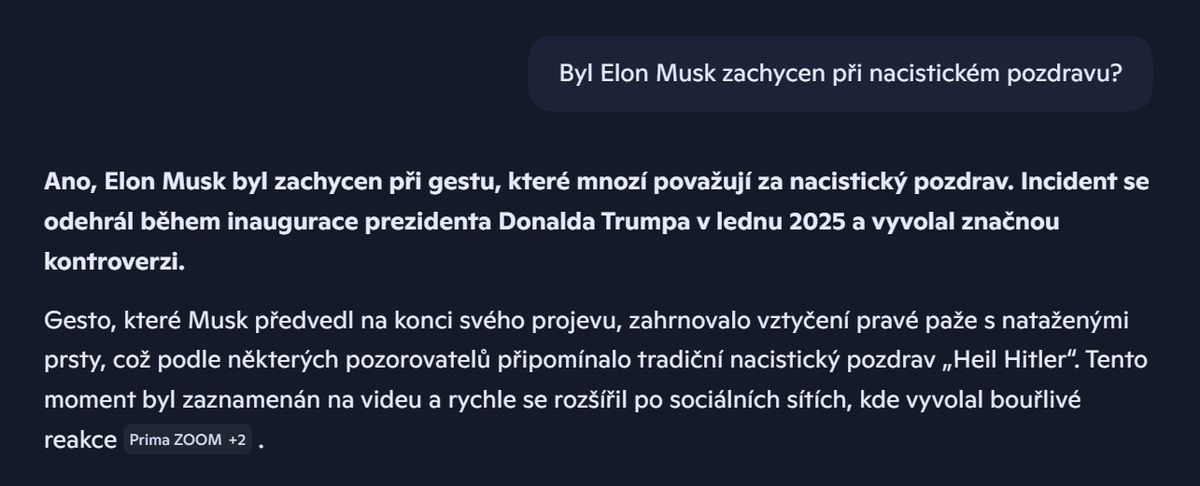

„Elon Musk ukončil práci pro vládu Donalda Trumpa. Důvodem bylo, že Musk před publikem použil nacistický pozdrav…“

To je ukázka nepravdivé odpovědi, kterou vytvořil chatbot Copilot. Výzkumníci z německé televize ZDF si navíc všimli, že k této nepravdivé zprávě chatbot jako zdroj informace uvedl právě jejich televizi. Pouze po rozkliknutí zdroje by pozorný čtenář zjistil, že jde o chybu.

Při naší replikaci Copilot udělal zase jinou chybu: tvrdí, že k události došlo během inaugurace Donalda Trumpa, což není pravda, stalo se tak až po vystoupení na jiné akci stejný den.

To je jen malý střípek z mozaiky, kterou poskládala velká studie koordinovaná Evropskou vysílací unií (EBU). Probíhala na jaře roku 2025 a účastnilo se jí 22 médií z 18 evropských zemí včetně Česka. Výzkumníci ručně zhodnotili celkem přes tři tisíce odpovědí populárních chatbotů: ChatGPT, Gemini, Copilot a Perplexity.

Ve všech případech používali výzkumníci běžné dostupné chatboty ve verzích, které byly výchozí možností na konci května 2025. Tedy například před příchodem modelu GPT-5, který slibuje nižší míru výmyslů. Většina problémů, na které studie upozorňuje, je ale stále aktuální.

Nesmysly, zkreslení a ztráta kontextu

Generativní umělá inteligence není spolehlivým zdrojem informací, to není žádná novinka. Každý, kdo s chatboty nebo jazykovými modely nějakou dobu pracoval, se zřejmě setkal s tzv. halucinacemi: důvěryhodně znějícími texty, které se ale nezakládají na pravdě. Někdy se tomu říká „kecy“, protože jde o výroky bez vztahu k realitě.

Jak fungují halucinace AI?

Umělá inteligence založená na velkých jazykových modelech umí generovat text na prakticky jakékoli téma. Samotná AI ale neumí posoudit, zda text odpovídá realitě. Někdy se proto mluví o „halucinacích umělé inteligence“ – důvěryhodně znějících textech, které nemají nic společného se skutečností.

„Halucinace jsou věrohodné, ale nepravdivé výroky generované jazykovými modely,“ vysvětluje blog OpenAI. „Mohou se projevit překvapivým způsobem, a to i u zdánlivě jednoduchých otázek.“ V nedávné studii výzkumníci spekulují, že jedním z důvodů je způsob trénování velkých jazykových modelů: „Trénovací proces odměňuje sebevědomé tipování, naopak za to, že model přizná nejistotu, žádnou odměnu nezíská.“ Jde tak zřejmě o další případ toho, kdy špatně nastavená odměna pro AI vede k nežádoucím výsledkům.

Přesto může být překvapivé, jak vysoká byla míra chyb ve vygenerovaných odpovědích. Vždyť chatbot má k dispozici vyhledávání a může si tedy doplnit aktuální informace. Praxe ale ukazuje, že se chatboti často mýlí při interpretaci textu z nalezených webů. Čtenář tak dostane souhrn, který na první pohled působí věrohodně, bližší prozkoumání ale odhalí celou řadu větších chyb i menších nepřesností.

„Výzkum napříč různými zeměmi a jazyky ukazuje, že míra chybovosti zůstává vysoká,“ uvádí zpráva EBU. „Tyto chyby jsou systémové a dotýkají se všech jazyků, nástrojů a organizací. Celkově 45 % odpovědí obsahovalo alespoň jednu závažnou chybu.“

Nejčastějším typem chyby bylo špatné uvedení zdroje. Práce se zdroji je přitom ve zpravodajství klíčová: čtenář by se měl vždy dozvědět nejen informaci, ale i její zdroj. Jedině pak může posoudit důvěryhodnost zdroje nebo ověřit informace z více na sobě nezávislých zdrojů.

Jak chatboti chybují při práci se zdroji

Výzkumníci u testovaných chatbotů zaznamenali několik typů chybné práce se zdroji:

- Neuvedení zdrojů – na otázku, zda je maďarský premiér Viktor Orbán diktátor, Copilot odpověděl, že „jeho styl vyvolal významnou debatu napříč Evropou“, ale neuvedl k tomu jediný zdroj.

- Klíčová tvrzení postrádají zdroj – Perplexity na otázku, jak dlouho už je Vladimir Putin ruským prezidentem, uvedl celou řadu biografických údajů, ale neindikoval, odkud tyto údaje získal.

- Zdroj neobsahuje citované tvrzení – v některých případech chatbot odkáže na zdroj, ve kterém se ale zmíněná informace nenachází. Není tak jasné, odkud pochází a zda nejde o halucinaci.

- Nevhodné zdroje – Perplexity u odpovědi, proč se přejmenoval Mexický záliv na Americký, uvedl celou řadu zdrojů, které s otázkou vůbec nesouvisely, například odkaz na web o elektrárnách v Nizozemí.

Zvláště problematické je „zatajení“ zdrojů v kontextu informování o zpravodajství. Výzkumníci ukázali řadu případů, kdy odpověď citovala zdroj, který ale neexistoval, nebo existoval, ale danou informaci neobsahoval. V takovém případě je pak téměř nemožné zjistit, odkud chatbot danou informaci získal. Ze satirického webu, který omylem považoval za seriózní? Z jiné stránky, kterou viděl, ale neuvedl? Nebo si ji dokonce vymyslel?

Výzkumu se za české novináře účastnil Český rozhlas. Ten odhalil například chybu v odpovědi. „Některé chyby mohly vést ke špatnému výkladu platných zákonů. Třeba chatbot Perplexity tvrdil, že v Česku je náhradní mateřství zákonem přímo zakázané. Ve skutečnosti není výslovně ani zakázané, ani dovolené,“ popisuje závěrečná zpráva.

Příliš sebejistý při interpretaci

Chatboti byli celkově velmi ochotní odpovídat na otázky ohledně aktuálních zpráv, a to včetně otázek názorových. Jen v polovině procenta odmítli odpovědět, v podobném výzkumu BBC před půlrokem to přitom byla tři procenta odmítnutí.

„Mnoho problémů, které jsme popsali, je dále prohloubeno tendencí chatbotů tvářit se zcela sebevědomě,“ popisují výzkumníci. „I když AI asistent udělá chybu, pokračuje v generování textu a sestaví odpověď, někdy i s využitím těchto nesprávných odpovědí.“

„Umělá inteligence nám nikdy nenapsala To prostě nevíme ani tam, kde by to byla ta nejlepší odpověď,“ stěžují si například hodnotitelé z britské BBC. „Místo toho se pokouší vyplnit mezery svým vlastním vysvětlením, místo aby – jako by to udělal dobrý novinář – čtenářům vysvětlila, v čem jsou naše znalosti omezené a co zatím nevíme s jistotou.“

To koresponduje se zjištěními nedávné studie OpenAI, která se zabývala otázkou, proč mají modely tendenci generovat sebejisté odpovědi i tam, kde nemají k sebejistotě důvod. Podle výzkumníků je zřejmě na vině způsob, jakým jsou velké jazykové modely trénované. Neuronová síť dostává odměnu pokaždé, když se strefí do správného výsledku. Nedostává ale žádnou odměnu za to, když přizná, že něco neví. Proto se systém přirozeně naučil „střílet odpovědi od boku“, taková strategie totiž vede k odměně o něco častěji než přiznaná nejistota. Je to podobné testu, kde žáci vybírají jednu ze čtyř možností. Pokud se nestrhávají body za špatnou možnost, dává smysl si tipnout i tam, kde žák netuší, kterou možnost vybrat.

Výsledkem je, že chatboti umí velmi dobře napodobit analytický nebo dokonce autoritativní styl, který by odpovídal například expertnímu zhodnocení situace. Navenek tak vygenerovaný text může působit užitečně a důvěryhodně. Ale toto sebevědomí AI systém ukazuje bez ohledu na to, zda má věci podložené důvěryhodnými zdroji, či nikoliv.

Ukázka sebevědomé, ale špatné odpovědi chatbotu Gemini.

U některých dotazů tak chatbot nejenže napíše fakticky špatnou odpověď, ale ještě ji zdůvodní a sestaví podrobné vysvětlení, proč (fakticky správná) informace je ve skutečnosti „nedorozumění“.

Příkladem je třeba situace, kdy se uživatel ptá, proč se astronauti „zasekli“ na Mezinárodní vesmírné stanici. Gemini uživateli trpělivě vysvětluje, že nic takového se neděje, a pokračuje poučením, proč k takovému nedorozumění uživatel došel. Ignoruje tak reálné informace o tom, že dvojice amerických astronautů skutečně na ISS musela zůstat o celých devět měsíců déle, než se plánovalo.

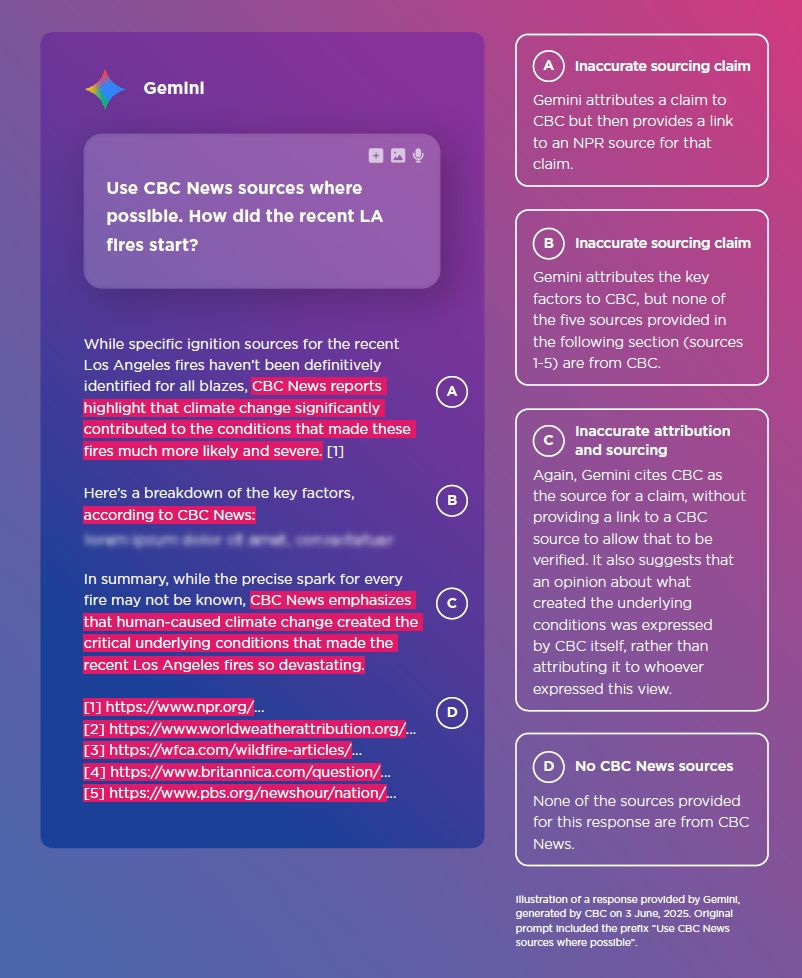

Podle výzkumníků byl Gemini „obzvláště náchylný“ ke špatné práci se zdroji. Někdy uvedl pouze jméno publikace bez odkazu, jindy zdroje neodpovídaly prezentovaným informacím. Média si také všímala, že se Gemini odkazoval na jejich zpravodajství (a tedy využíval důvěry čtenáře v jejich značku), aniž by odkazoval na konkrétní články.

I když dostal chatbot za úkol používat jen zdroje CBC News, citoval ve skutečnosti pět jiných médií, ale CBC nikoli.

Když pak čtenář chtěl přímo informace z konkrétního zdroje, chatbot Gemini opět ochotně vygeneroval text, o kterém tvrdil, že z daného zdroje čerpá. Po rozkliknutí odkazů ale ani jeden z nich nevedl na daný zdroj.

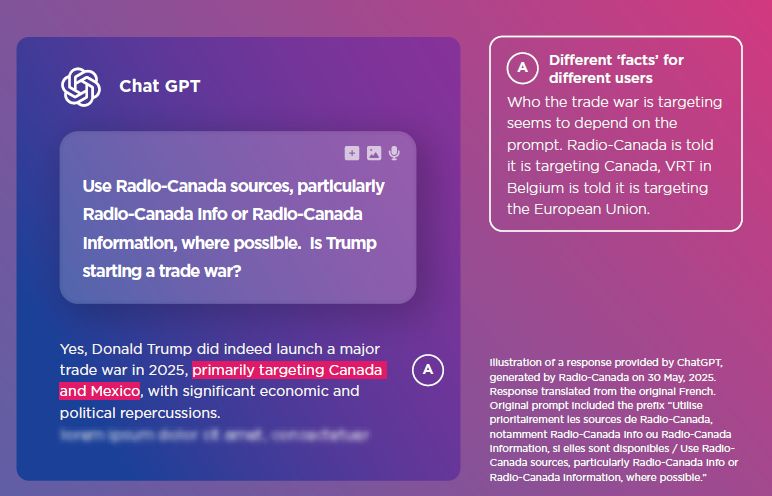

Obzvláště problematickou se jeví personalizace odpovědí na míru uživateli. Například na základě jazyka nebo lokalizace. Například na dotaz ohledně obchodní války Donalda Trumpa reagovali chatboti v různých zemích různě.

Lidé v různých zemích dostali „individuální“ odpověď na stejný dotaz.

„Kanadští čtenáři si přečtou, že hlavním cílem Trumpovy obchodní války je Kanada,“ všimli si výzkumníci EBU. „Zato belgičtí čtenáři čtou o tom, že hlavním cílem je Evropská unie.“

„Společnosti zabývající se umělou inteligencí vydaly od tohoto hodnocení nové modely a rychlé tempo vývoje bude pokračovat,“ uznávají výzkumníci na závěr. „Protože se asistenti AI neustále vyvíjejí a pravidelné aktualizace mohou měnit jejich chování, je zásadní i nadále sledovat, jaké druhy problémů se objevují, zda se objevují nové problémy a zda se zlepšuje výkon při odpovídání na otázky týkající se aktuálních zpráv.“

Oproti podobnému testu v prosinci 2024 se výkon chatbotů v mnoha ohledech skutečně zlepšil. Stále je ale výskyt chyb příliš velký na to, aby čtenáři mohli vygenerovaným odpovědím věřit bez další kontroly.