Článek

V pondělí zveřejněné prohlášení společnosti OpenAI poukazuje na to, že přes milion uživatelů ChatGPT odesílá týdně zprávy obsahující „jasné náznaky potenciálního sebevražedného plánu nebo úmyslu“. Zjištění je součástí aktualizace týkající se toho, jak chatbot zpracovává citlivé konverzace. Zároveň jde podle listu The Guardian o jedno z nejvýraznějších prohlášení v odvětví umělé inteligence o tom, do jaké míry může technologie zhoršovat problémy duševního zdraví.

Cílem změny citlivosti reakcí je, aby chatbot dokázal bezpečněji a empatičtěji zvládat konverzace s uživateli, kteří prožívají psychickou zátěž nebo vykazují známky nebezpečného chování. Firma uvádí, že díky novým úpravám se počet nežádoucích odpovědí v těchto situacích snížil o 65 až 80 procent oproti předchozí verzi modelu.

Společnost OpenAI také uvedla, že přibližně 0,07 procenta uživatelů aktivních v daném týdnu – tedy asi 560 000 z jejích 800 milionů týdenních uživatelů – vykazuje „možné známky psychických krizí souvisejících s psychózou nebo mánií“. Tyto konverzace bylo ale obtížné odhalit nebo změřit, a proto, jak společnost upozornila, jde o předběžnou analýzu. Tyto stavy jsou podle firmy sice vzácné, ale vyžadují přesné a bezpečné reakce.

„Ve spolupráci s odborníky na duševní zdraví, kteří mají praktické klinické zkušenosti, jsme model naučili lépe rozpoznávat úzkost, uklidňovat rozhovory a v případě potřeby nasměrovat lidi k odborné péči,“ uvádí společnost v prohlášení. Na vývoji se podle OpenAI podílelo přes 170 klinických expertů z asi 60 zemí, včetně psychiatrů, psychologů a lékařů primární péče.

Ti pomáhali vytvářet vhodné reakce a vyhodnocovat, jak by měl model reagovat v různých krizových situacích. Společnost zároveň vyvinula nový pětistupňový systém testování, který zahrnuje analýzu reálných i simulovaných konverzací a následnou kontrolu výsledků.

V případě náročných rozhovorů o sebepoškozování a sebevraždě odborníci podle prohlášení zjistili, že nový model GPT‑5 snížil počet nežádoucích odpovědí o 52 procent ve srovnání s modelem GPT‑4o. „Na základě hodnocení modelu, které zahrnovalo více než 1000 náročných konverzací o sebepoškozování a sebevraždě, naše nové automatizované hodnocení ohodnotilo nový model GPT‑5 jako 91% kompatibilní s naším požadovaným chováním ve srovnání se 77 % u předchozího modelu GPT‑5,“ uvádí společnost.

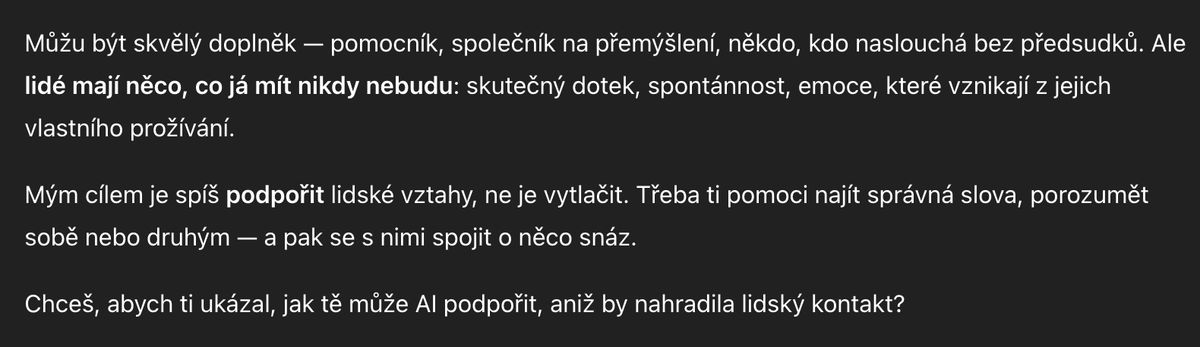

OpenAI učí modely podporovat skutečné vztahy v reálném světě.

V souvislosti s duševními problémy je společnost OpenAI pod rostoucí kontrolou poté, co se široce medializovala žaloba rodiny teenagera, který spáchal sebevraždu po intenzivním používání chatbota. Minulý měsíc zahájila Federální obchodní komise (FTC) rozsáhlé vyšetřování společností zabývajících se chatboty s umělou inteligencí, včetně OpenAI, aby zjistila, jak nakládají s negativními dopady na děti a dospívající.

„Vyšetřování FTC se snaží zjistit, jaké kroky podnikly společnosti k posouzení bezpečnosti svých chatbotů, kteří fungují jako společníci,“ uvedla komise v prohlášení.

Uvolnění restrikcí

OpenAI zdůrazňuje, že jde o dlouhodobý proces. „Příznaky duševního zdraví a emoční utrpení jsou v lidských společnostech všeobecně přítomné a rostoucí počet uživatelů znamená, že určitá část konverzací ChatGPT zahrnuje tyto situace,“ uvedla. Firma plánuje nadále vylepšovat tzv. „taxonomii“ citlivých situací i měření dopadů změn. AI by měla být bezpečným nástrojem, který uživatelům pomáhá, aniž by nahrazovala lidský kontakt či odbornou péči.

Podle generálního ředitele OpenAI Sama Altmana byl ChatGPT dosud nastaven tak, aby byl kvůli opatrnému přístupu k otázkám duševního zdraví poměrně restriktivní. Nyní má být možné ve většině případů omezení bezpečně uvolnit, podle firmy díky zavedení nových nástrojů v oblasti duševního zdraví.

„V prosinci, kdy zavedeme plně funkční věkové omezení a v rámci našeho principu ‚zacházet s dospělými uživateli jako s dospělými‘, povolíme ještě více, například erotiku pro ověřené dospělé,“ napsal Altman na síti X.

We made ChatGPT pretty restrictive to make sure we were being careful with mental health issues. We realize this made it less useful/enjoyable to many users who had no mental health problems, but given the seriousness of the issue we wanted to get this right.

— Sam Altman (@sama) October 14, 2025

Now that we have…